Resumo:

– O Google está construindo seu próprio hardware e software de rede para redes de dados de datacenter.

– Sua geração atual, Júpiter Fabrics, pode entregar mais de 1 petabit/s de largura de banda de bissecção total.

– O Google usa uma topologia de fechamento, uma pilha de controle de software centralizada e protocolos personalizados para projetar suas redes de datacenter.

– Eles estão implantando e desfrutando dos benefícios da rede definida por software (SDN) há uma década.

– As redes de datacenter do Google são construídas para velocidade, modularidade e disponibilidade e são infraestrutura compartilhada.

– Andrômeda é a mais recente pilha de rede do Google Cloud Platform, com base na rede definida por software (SDN).

– O Google está construindo um novo data center em Nebraska como parte de seus US $ 9.5 bilhões de investimentos em data centers e escritórios.

Perguntas únicas:

1. Como o Google está construindo sua infraestrutura de rede de datacenter?

O Google tem construído seu próprio hardware e software de rede para conectar todos os servidores em seus datacenters, alimentando seus sistemas de computação e armazenamento distribuídos. Eles têm feito isso na última década.

2. Qual é a capacidade da rede de datacenter de geração atual do Google?

A geração atual, chamada Júpiter Fabrics, pode entregar mais de 1 petabit/s de largura de banda de bissecção total. Essa capacidade é suficiente para 100.000 servidores trocarem informações a 10 GB/s cada.

3. Como o Google projeta suas redes de datacenter?

O Google usa uma topologia de fechamento, que envolve organizar sua rede em torno de uma coleção de interruptores menores para fornecer as propriedades de um interruptor lógico muito maior. Eles também usam uma pilha de controle de software centralizada para gerenciar milhares de interruptores dentro do data center, fazendo -os agir como um tecido grande. Além disso, eles constroem seu próprio software e hardware usando protocolos personalizados adaptados ao data center.

4. Há quanto tempo o Google está implantando e aproveitando os benefícios da rede definida por software (SDN)?

O Google está implantando e aproveitando os benefícios do SDN há uma década. Eles usaram o SDN para alimentar seu datacenter wan, b4 e sua pilha de virtualização de rede SDN, Andromeda.

5. Quais são os principais recursos das redes de datacenter do Google?

As redes de datacenters do Google oferecem velocidade, modularidade e disponibilidade sem precedentes. Eles são constantemente atualizados para atender às demandas de largura de banda de sua última geração de servidores. Essas redes também são infraestrutura compartilhada, alimentando a infraestrutura e os serviços internos do Google, bem como a plataforma do Google Cloud.

6. O que é Andrômeda e como isso se relaciona com o Google Cloud Platform?

Andromeda é um substrato baseado em rede definido por software (SDN) para os esforços de virtualização de rede do Google. É o ponto de orquestração para provisionar, configurar e gerenciar redes virtuais e processamento de pacotes em rede na plataforma do Google Cloud.

7. Qual é o plano de investimento do Google para data centers e escritórios?

O Google planeja investir $ 9.5 bilhões em data centers e escritórios e, como parte desse plano, eles estão construindo um novo data center em Nebraska.

8. Por que o Google constrói seu próprio hardware e software de rede para redes de datacenter?

O Google começou a construir seu próprio hardware e software de rede porque não havia soluções existentes que pudessem atender aos seus requisitos de computação distribuídos. Eles continuaram a fazer isso para garantir uma ótima infraestrutura de computação para seus datacenters.

9. Quais são os princípios que o Google usou no design de suas redes de datacenter?

O Google usou três princípios principais no design de suas redes de datacenter: organizar a rede em torno de uma topologia de fechamento, usando uma pilha de controle de software centralizada e construindo seu próprio software e hardware usando protocolos personalizados adaptados ao data center.

10. Por que as redes de datacenter do Google são consideradas infraestrutura compartilhada?

As redes de datacenter do Google alimentam sua infraestrutura e serviços internos, bem como a plataforma do Google Cloud. Isso significa que as mesmas redes são acessíveis aos desenvolvedores em todo o mundo, permitindo que eles aproveitem a infraestrutura de rede de classe mundial sem precisar construí-lo.

11. Como o Google garante a disponibilidade de suas redes de datacenter?

A equipe de operações do Google implantou e reimplantou várias gerações de sua rede em sua infraestrutura para atender às necessidades de largura de banda de seus sistemas distribuídos. Eles trabalham em estreita colaboração com a melhor equipe de engenharia e operações de rede do mundo para garantir a disponibilidade de suas redes.

12. Qual é o objetivo de Andrômeda na plataforma do Google Cloud?

Andromeda serve como ponto de orquestração para provisionar, configurar e gerenciar redes virtuais e processamento de pacotes de rede na plataforma do Google Cloud. É um componente essencial dos recursos de rede da plataforma.

13. Como a infraestrutura de rede de datacenter do Google utiliza rede de rede definida por software (SDN)?

O Google está implantando o SDN em sua infraestrutura de rede de datacenters por uma década. Eles usaram o SDN para alimentar seu datacenter wan, b4, bem como sua pilha de virtualização de rede, Andromeda. Eles adotaram as idéias arquitetônicas do SDN em seus sistemas de rede.

14. Qual é o significado do investimento do Google em data centers e escritórios?

Investimento do Google de US $ 9.5 bilhões em data centers e escritórios refletem seu compromisso de expandir sua infraestrutura e recursos. Ele demonstra sua confiança no crescimento de seus serviços e na crescente demanda pelo Google Cloud.

15. Como a infraestrutura de rede de datacenter do Google contribui para o Google Cloud Platform?

A infraestrutura de rede de datacenter do Google é infraestrutura compartilhada que alimenta a infraestrutura e os serviços internos do Google, bem como a plataforma do Google Cloud. Isso permite que os desenvolvedores de todo o mundo alavancem a infraestrutura de rede de classe mundial sem precisar construí-lo, permitindo que eles criem serviços e plataformas inovadoras de Internet.

O Google revela o novo data center de US $ 750 milhões como parte de US $ 9.Gol de 5b

O aprendizado de máquina é parte integrante de lidar com o big data. Como Ryan Den Rooijen, líder global de capacidades, Insights & Innovation, disse antes da Cúpula de Innovação de Big Data em Londres (março de 2017), “A maioria dos problemas que observei se relaciona com como tornar esses dados úteis … para gerar impacto significativo nos negócios.” Portanto, além de usar o aprendizado de máquina para produtos como o Google Translate, o Google também usa suas redes neurais para prever o PUE de seus data centers.

Google possui o próprio datacenter

Infraestrutura de VP e GM, Sistemas e Serviços

O Google tem sido pioneiro em computação distribuída e processamento de dados, do sistema de arquivos do Google para MapReduce a BigTable e Borg. Desde o início, nós’Sabe -se que ótima infraestrutura de computação como essa requer ótima tecnologia de rede de datacenter. Mas quando o Google estava começando, ninguém fez uma rede de datacenter que poderia atender aos nossos requisitos de computação distribuída.

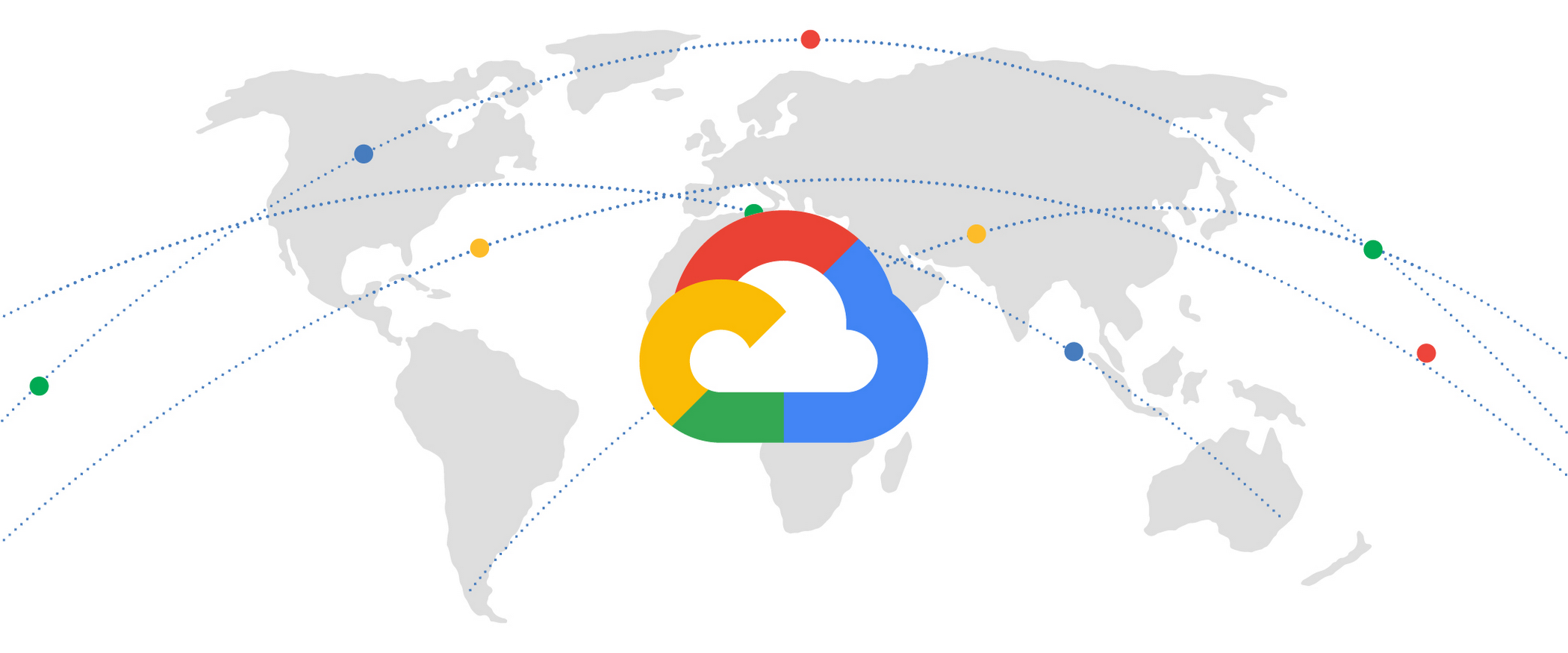

Então, na última década, estamos construindo nosso próprio hardware e software de rede para conectar todos os servidores em nossos datacenters, alimentando nossos sistemas de computação e armazenamento distribuídos. Agora, abrimos esta infraestrutura poderosa e transformadora para uso por desenvolvedores externos através do Google Cloud Platform.

Na cúpula de rede aberta de 2015, revelamos pela primeira vez os detalhes de cinco gerações de nossa tecnologia de rede interna. De Firehose, nossa primeira rede interna de datacenter, há dez anos até a nossa rede de última geração Jupiter, nós’aumentou a capacidade de uma única rede de datacenter mais de 100x. Nossa geração atual – Júpiter Fabrics – pode fornecer mais de 1 petabit/s de largura de banda de bissecção total. Para colocar isso em perspectiva, essa capacidade seria suficiente para 100.000 servidores trocarem informações a 10 GB/s, o suficiente para ler todo o conteúdo digitalizado da Biblioteca do Congresso em menos de 1/10 de um segundo.

Utilizamos três princípios principais no design de nossas redes de datacenter:

- Organizamos nossa rede em torno de uma topologia de fechamento, uma configuração de rede em que uma coleção de interruptores menores (mais baratos) é organizada para fornecer as propriedades de um interruptor lógico muito maior.

- Usamos uma pilha de controle de software centralizada para gerenciar milhares de comutadores dentro do data center, fazendo com que eles atuam efetivamente como um tecido grande.

- Construímos nosso próprio software e hardware usando o silício de fornecedores, confiando menos nos protocolos padrão da Internet e muito mais em protocolos personalizados adaptados ao data center.

Tomados em conjunto, nossa pilha de controle de rede tem mais em comum com o Google’s Arquiteturas de computação distribuídas do que os protocolos de Internet tradicionais centrados no roteador. Alguns podem até dizer que nós’Estive implantando e aproveitando os benefícios da rede definida por software (SDN) no Google por uma década. Alguns anos atrás, revelamos como o SDN está alimentando o Google’s datacenter wan, b4, um do mundo’s Maiores Wans. No ano passado, mostramos os detalhes do GCP’Stack de virtualização de rede SDN, Andrômeda. De fato, as idéias arquitetônicas para ambos os sistemas vêm de nossos primeiros trabalhos em redes de datacenter.

Construir ótimas redes de data center não é apenas criar um excelente hardware e software. Isto’é sobre parceria com o mundo’a melhor equipe de engenharia e operações de rede desde o primeiro dia. Nossa abordagem para a rede muda fundamentalmente a organização da rede’s Dados, controle e aviões de gerenciamento. Uma mudança tão fundamental não vem sem alguns solavancos, mas nossa equipe de operações mais do que enfrentou o desafio. Nós’VE implantou e reimplantou várias gerações de nossa rede em nossa infraestrutura em escala planetária para acompanhar as necessidades de largura de banda de nossos sistemas distribuídos.

Juntando tudo isso, nossas redes de datacenter oferecem velocidade sem precedentes na escala de edifícios inteiros. Eles são construídos para modularidade, constantemente atualizados para atender às demandas insaciáveis da largura de banda da última geração de nossos servidores. Eles são gerenciados para disponibilidade, atendendo aos requisitos de tempo de atividade de alguns dos serviços e clientes mais exigentes da Internet. Mais importante ainda, nossas redes de datacenter são infraestrutura compartilhada. Isso significa que as mesmas redes que alimentam todo o Google’S Infraestrutura e Serviços Internos também alimentam a plataforma do Google Cloud. Estamos mais empolgados em abrir esse recurso para desenvolvedores em todo o mundo, para que o próximo grande serviço ou plataforma de Internet possa aproveitar a infraestrutura de rede de classe mundial sem ter que inventá-lo.

Google Cloud

Entre na zona de Andromeda: mais recente pilha de rede da plataforma do Google Cloud

Andrômeda é um substrato baseado em rede definido por software (SDN) para nossos esforços de virtualização de rede. É o ponto de orquestração para provisionamento, configuração e gerenciamento de redes virtuais e processamento de pacotes em rede.

Por Amin Vahdat • Leia de 3 minutos

- Google Cloud

- A infraestrutura

- Sistemas

O Google revela o novo data center de US $ 750 milhões como parte de US $ 9.Gol de 5b

À medida que a demanda pelo Google Cloud Soars, o Google está construindo um novo data center em Nebraska como parte de sua estratégia para investir US $ 9.5 bilhões em data centers e escritórios em 2022.

O Google está cumprindo sua promessa de gastar US $ 9.5 bilhões em novos data centers e escritórios do Google em 2022 com a apresentação de um novo data center de US $ 750 milhões em Nebraska.

O enorme novo campus do Google em Omaha, Neb., consistirá em quatro edifícios totalizando mais de 1.4 milhões de pés quadrados como a demanda por serviços e infraestrutura do Google Cloud está subindo. No Google Cloud’s Recente quarto trimestre, a empresa relatou um crescimento de vendas de 45 % ano após ano, para US $ 5.5 bilhões.

“[O novo data center] trará mais oportunidades para a comunidade local e mais recursos para nossos clientes expandirem seus negócios e usar os serviços digitais,” disse Stacy Trackey Meagher, diretor administrativo do Google Cloud’S Região Central, em uma declaração.

O novo Data Center do Google em Nebraska faz parte do Mountain View, Califórnia.-Pesquisa baseada e gigante em nuvem’S planeja investir um total de US $ 9.5 bilhões em data centers e u.S.-escritórios baseados até o final de 2022.

O Google é um dos maiores gastadores na construção de novos data centers em todo o mundo, de acordo com o Synergy Research Group, investindo bilhões a cada ano na construção e equipamento de data centers de escala de hiperesclar para atender às crescentes demandas de clientes em nuvem. Google, Amazon Web Services e Microsoft têm as pegadas de data center mais amplas do mundo, com cada hospedagem pelo menos 60 ou mais locais de data centers.

Data centers são os “âncoras vitais” Para clientes e comunidades locais, disse o CEO do Google Sundar Pichai em um post no blog este mês.

“Nossos investimentos em data centers continuarão a alimentar as ferramentas e serviços digitais que ajudam pessoas e empresas a prosperar,” disse Google’S Pichai.

Google’s Planos de expansão do data center

Além do novo data center em Nebraska, o Google planeja gastar bilhões este ano em data centers na Geórgia, Iowa, Oklahoma, Nevada, Tennessee, Virgínia e Texas.

“No u.S. Nos últimos cinco anos, nós’Investiu mais de US $ 37 bilhões em nossos escritórios e data centers em 26 estados, criando mais de 40.000 empregos em período integral. Que’s Além dos mais de US $ 40 bilhões em pesquisa e desenvolvimento, investimos no U.S. em 2020 e 2021,” disse Pichai.

Os data centers permitem que o Google Cloud Services and Infrastructure, incluindo sua principal oferta de plataforma do Google Cloud (GCP).

Em 2021, o GCP registrou mais de 80 % de crescimento no volume total de negócios em comparação com 2020, e mais de 65 % de crescimento no número de negócios que excedam US $ 1 bilhão.

No geral, o Google Cloud agora tem uma taxa de receita anualizada de US $ 22.16 bilhões.

Google Data Center FAQ Parte 3

Como o Google decide onde construir seus data centers?

O Google escolhe os locais de seus data centers com base em uma combinação de fatores que incluem localização do cliente, força de trabalho disponível, proximidade à infraestrutura de transmissão, descontos fiscais, taxas de serviços públicos e outros fatores relacionados. Seu foco recente na expansão de sua infraestrutura em nuvem adicionou mais considerações, como a demanda de clientes corporativos em nuvem por determinados locais e a proximidade de centros populacionais de alta densidade.

A escolha de ST. Ghislain, Bélgica, para um data center (inaugurado em 2010), foi baseado na combinação de infraestrutura energética, terras desenvolvíveis, um forte apoio local a empregos de alta tecnologia e a presença de um conjunto de empresas que apóiam ativamente a educação tecnológica nas escolas e universidades próximas.

Um clima de negócios positivo é outro fator. Isso, juntamente com a terra e o poder disponível, tornou Oklahoma particularmente atraente, de acordo com o Google’s Diretor Sênior de Operações quando o site de Pryor Creek foi anunciado. No Oregon, o ambiente de negócios positivo significa localizar em um estado que não tem imposto sobre vendas. Os comissários locais do condado de Wasco também isentaram o Google pela maioria de seus impostos sobre a propriedade, exigindo que ele faça um pagamento único de US $ 1.7 para governos e pagamentos locais de pelo menos US $ 1 milhão a cada ano depois.

A proximidade com as fontes de energia renovável também está se tornando cada vez mais importante. O Google é estrategicamente investido em recursos renováveis e considera sua pegada ambiental ao situar novos data centers.

Os data centers do Google usam energia renovável?

Google compra mais energia renovável do que qualquer corporação do mundo. Em 2016, comprou energia suficiente para explicar mais da metade do seu uso de energia. Em 2017, a empresa espera compensar completamente todo o seu uso de energia com 100 % de energia renovável. Para fazer isso, o Google assinou 20 contratos de compra para 2.6 gigawatts (GW) de energia renovável. Isso significa que, embora a energia renovável possa não estar disponível em todos os lugares ou nas quantidades que o Google precisa, o Google compra a mesma quantidade de energia renovável que consome.

O Google também comprometeu US $ 2.5 bilhões em financiamento de ações para desenvolver energia solar e eólica que pode ser adicionada à rede elétrica em todo o mundo. Essa disposição de financiar projetos renováveis está na tentativa de expandir gradualmente o mercado de energia renovável em termos de disponível, bem como alterando as maneiras pelas quais a energia renovável pode ser comprada. No processo, o uso de fontes renováveis se torna mais fácil e mais econômico para todos.

Vista do Google Data Center em Hamina, Finlândia, com uma turbina eólica ao lado dele

A sustentabilidade é um foco dentro dos data centers também. O st. Ghislain, Bélgica, data centers eram Google’é o primeiro a confiar inteiramente em resfriamento grátis. E essa instalação’S Planta de purificação de água no local permite que os data centers lá reciclem água de um canal industrial, em vez de tocar na região’s abastecimento de água doce.

Quanta energia o Google Data Centers usa?

O uso de energia do data center representa um pedaço considerável dos 5.7 TERAWATT HORAS sua empresa controladora, Alphabet, usada em 2015. Com uma pue média de 1.12 (versus a média da indústria de 1.7), o Google diz que seus data centers usam metade da energia de um data center típico. Uma parte crescente disso é renovável, fornecida através de contratos de compra de energia.

Que tipo de hardware e software o Google usa em seus data centers?

Isto’Não é segredo de que o Google construiu sua própria infraestrutura da Internet desde 2004 a partir de componentes de commodities, resultando em data centers de dados definidos por software e definidos por software. O design hierárquico de malha resultante é padrão em todos os seus data centers.

O hardware é dominado pelos servidores personalizados projetados pelo Google e Júpiter, o Switch Google introduzido em 2012. Com suas economias de escala, o Google contrata diretamente com os fabricantes para obter as melhores ofertas.

Yevgeniy Sverdlik

Google’S Jupiter Networking Switches On Display no Google Cloud Next 2017 em San Francisco

Google’S servidores e software de rede executam uma versão endurecida do sistema operacional de código aberto Linux. Programas individuais foram escritos internamente. Eles incluem, até onde sabemos:

- Google Web Server (GWS)-servidor web personalizado baseado em Linux que o Google usa para seus serviços online.

- Sistemas de armazenamento:

- Colossus-o sistema de arquivos no nível do cluster que substituiu o sistema de arquivos do Google

- Cafeína – Um sistema de indexação contínua lançada em 2010 para substituir o teragoogle

- Hummingbird – algoritmo de índice de pesquisa principal introduzido em 2013.

O Google também desenvolveu várias abstrações que ele usa para armazenar a maioria de seus dados:

- Buffers de protocolo-uma maneira neutra em linguagem, neutra em plataforma e extensível de serializar dados estruturados para uso em protocolos de comunicação, armazenamento de dados e muito mais

- Sstable (tabela de cordas classificadas) – um mapa persistente, ordenado e imutável de chaves para valores, onde as chaves e os valores são strings de byte arbitrários. Também é usado como um dos blocos de construção do BIGTABLE

- Recordio – um arquivo que define interfaces de IO Compatível com o Google’S Especificações de IO

Como o Google usa o aprendizado de máquina em seus data centers?

O aprendizado de máquina é parte integrante de lidar com o big data. Como Ryan Den Rooijen, líder global de capacidades, Insights & Innovation, disse antes da Cúpula de Innovação de Big Data em Londres (março de 2017), “A maioria dos problemas que observei se relaciona com como tornar esses dados úteis … para gerar impacto significativo nos negócios.” Portanto, além de usar o aprendizado de máquina para produtos como o Google Translate, o Google também usa suas redes neurais para prever o PUE de seus data centers.

O Google calcula a PUE a cada 30 segundos e rastreia continuamente a carga, a temperatura externa do ar e os níveis para equipamentos mecânicos e de resfriamento. Esses dados permitem que os engenheiros do Google desenvolvam um modelo preditivo que analisa as interações complexas de muitas variáveis para descobrir padrões que podem ser usados para ajudar a melhorar o gerenciamento de energia. Por exemplo, quando o Google levou alguns servidores offline por alguns dias, os engenheiros usaram esse modelo para ajustar o resfriamento para manter a eficiência energética e economizar dinheiro. O modelo é 99.6 % precisos.

Em julho de 2016, o Google anunciou os resultados de um teste de um sistema de IA por sua aquisição britânica DeepMind. Esse sistema reduziu o consumo de energia de suas unidades de resfriamento de data center em até 40% e em 15%. O sistema prevê temperaturas com uma hora de antecedência, permitindo que o resfriamento seja ajustado em antecipação.

O Google arrendando espaço em outras empresas’ Data centers?

Sim. O Google aluga espaço de outros quando faz sentido. Nem todo data center do Google tem seu nome na porta. Em vez disso, a empresa usa uma variedade de estratégias para atender às suas necessidades de data center. Ele aluga espaço para sites de armazenamento em cache, por exemplo, e usa uma estratégia de construção e arrendamento misto para seu lançamento global de data center em nuvem.

Google possui o próprio datacenter

Amin Vahdat

Infraestrutura de VP e GM, Sistemas e Serviços

As redes de data center formam a base para a escala de armazém moderna e a computação em nuvem. A garantia subjacente de comunicação uniforme e arbitrária entre dezenas de milhares de servidores a 100s de GB/s de largura de banda com latência de sub-100us transformou a computação e o armazenamento. O principal benefício desse modelo é simples, mas profundo: adicionar um servidor incremental ou dispositivo de armazenamento a um serviço de nível superior oferece um aumento proporcional na capacidade e capacidade de serviço. No Google, nossa tecnologia de rede de data center Júpiter suporta esse tipo de capacidade de expansão para serviços fundamentais para nossos usuários, como pesquisa, YouTube, Gmail e serviços em nuvem, como IA e aprendizado de máquina, mecanismo de computação, análise de bigQuery, bancos de dados de alvo de spra e mais dezenas.

Passamos os últimos oito anos integrando profundamente a comutação de circuito óptico (OCS) e a multiplexação da divisão de ondas (WDM) em Júpiter. Enquanto décadas de sabedoria convencional sugeriam que isso era impraticável, a combinação de OCs com nossa arquitetura de rede definida por software (SDN) permitiu novos recursos: suporte para construções de rede incremental com tecnologias heterogêneas; maior desempenho e menor latência, custo e consumo de energia; Prioridade de aplicação em tempo real e padrões de comunicação; e atualizações de tempo zero. Júpiter faz tudo isso enquanto reduz a conclusão do fluxo em 10%, melhorando a taxa de transferência em 30%, usando 40% menos energia, incorrendo 30% menos custo e entregando 50x menos tempo de inatividade que as alternativas mais conhecidas. Você pode ler mais sobre como fizemos isso no artigo que apresentamos no SigComm 2022 hoje, Júpiter evoluindo: transformando a rede de datacenter do Google por meio de interruptores de circuitos ópticos e redes definidas por software.

Aqui está uma visão geral deste projeto.

Redes de data center em evolução do Júpiter

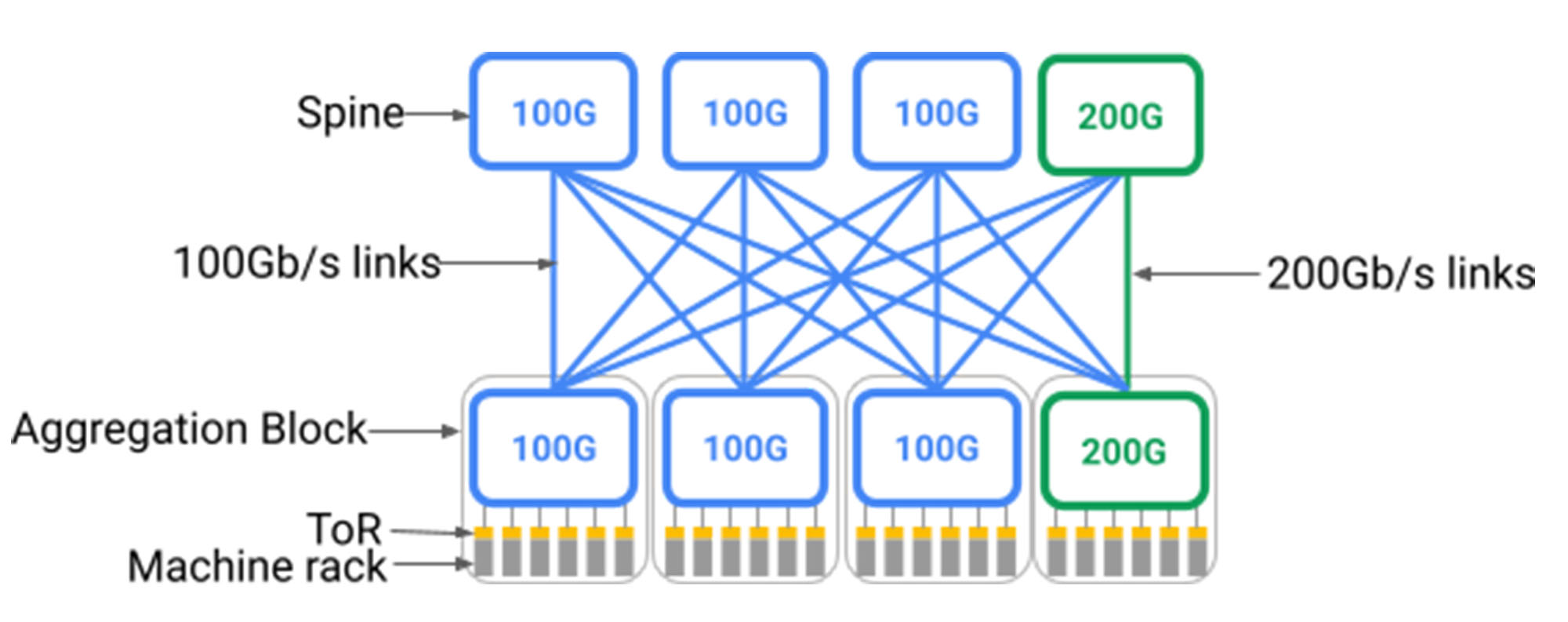

Em 2015, mostramos como nossas redes de data center Júpiter escalaram para mais de 30.000 servidores com conectividade por servidor de 40 GB/s uniforme, suportando mais de 1pb/s de largura de banda agregada. Hoje, Júpiter suporta mais de 6pb/s de Datacenter BandWidth. Entregamos esse nível nunca visto de desempenho e escala, alavancando três idéias:

- Rede definida por software (SDN) – Um plano de controle hierárquico e hierárquico logicamente centralizado para programar e gerenciar os milhares de chips de comutação na rede de data center.

- Topologia Clos – Uma topologia de comutação de vários estágios sem bloqueio, construída com chips de comutador de radix menores, que podem escalar para redes arbitrariamente grandes.

- Switch de comerciante silício – Componentes de comutação Ethernet de uso geral e econômicos para uma rede de dados e rede de dados convergente.

Construindo nesses três pilares, Júpiter’S abordagem arquitetônica apoiou uma mudança marítima na arquitetura de sistemas distribuídos e definiu o caminho de como a indústria como um todo constrói e gerencia as redes de data centers.

No entanto, dois desafios principais para data centers de escala de hiperesconomia permaneceram. Primeiro, as redes de data center precisam ser implantadas na escala de um edifício inteiro – talvez 40MW ou mais da infraestrutura. Além disso, os servidores e dispositivos de armazenamento implantados no edifício estão sempre evoluindo, por exemplo, passando de 40 GB/s para 100 GB/s para 200 GB/se hoje e hoje 400 GB/s Interconexões de rede nativa. Portanto, a rede de data center precisa evoluir dinamicamente para acompanhar os novos elementos que se conectam a ele.

Infelizmente, como mostrado abaixo, as topologias fechadas requerem uma camada de coluna com suporte uniforme para os dispositivos mais rápidos que podem se conectar a ele. A implantação de uma rede de data center em escala de edifício, baseada em clos. Isso ocorre porque as topologias fechadas exigem inerentemente tudo para tudo Fanout dos blocos de agregação 1 para a coluna; Adicionando à coluna gradualmente exigiria a religação de todo o data center. Uma maneira de suportar novos dispositivos em execução a taxas de linha mais rápidas seria substituir toda a camada da coluna para suportar a velocidade mais recente, mas isso seria impraticável, dadas centenas de racks individuais que abrigam os interruptores e dezenas de milhares de pares de fibras que atravessam o edifício.

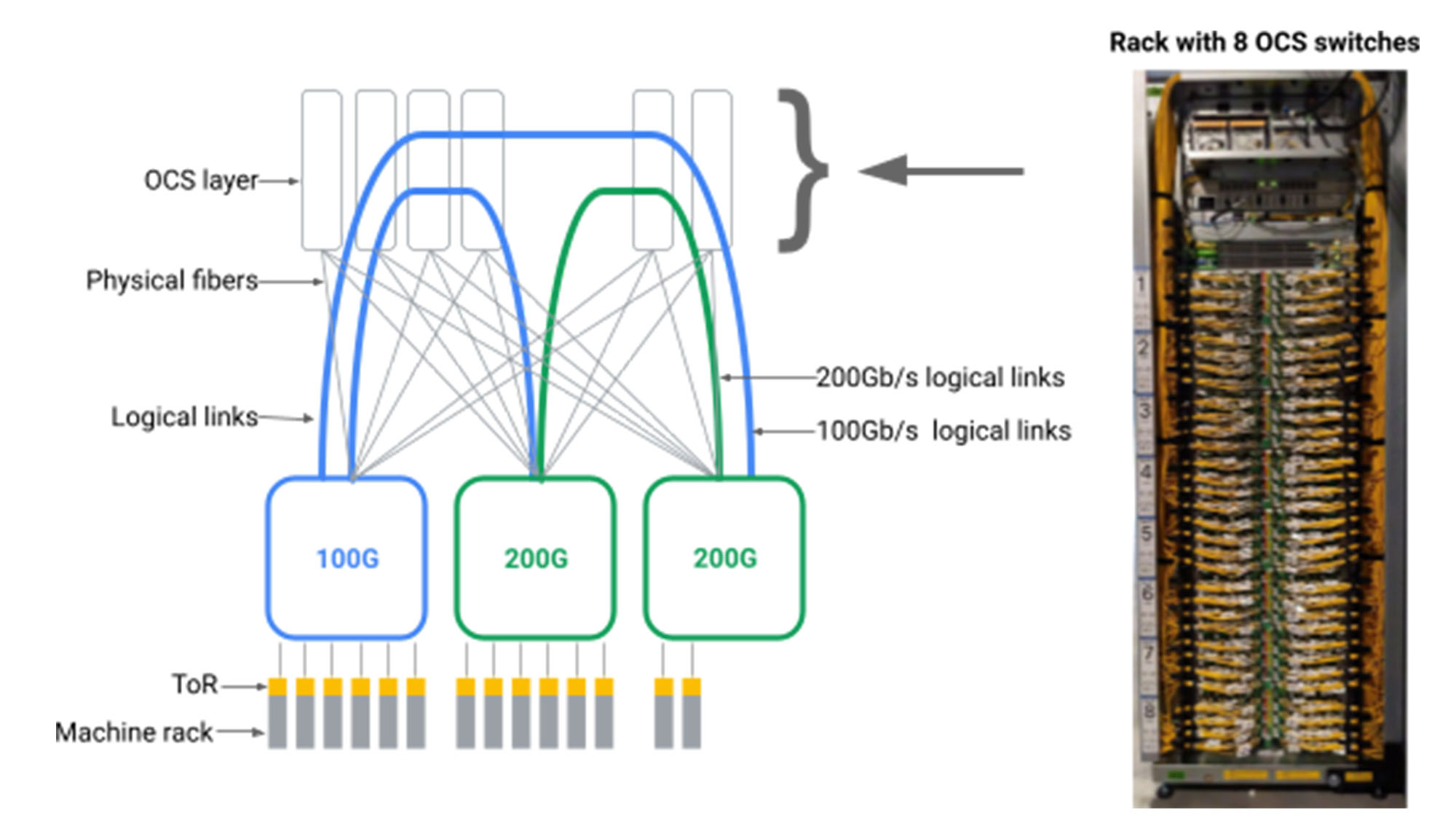

Figo. Um novo bloco de agregação (verde) com velocidade de porta de 200 GB/s é conectado a 3 blocos de coluna antigos (azul) com velocidade de porta de 100 GB/s e um novo bloco de coluna vertebral (verde) com velocidade de porta 200 GB/s. Neste modelo, apenas 25% dos links do novo bloco de agregação e o novo bloco de espinha é executado a 200 GB/s.

Idealmente, a rede de data center suportaria elementos de rede heterogêneos em um “Pague à medida que você cresce” Modelo, adicionando elementos de rede somente quando necessário e apoiando a última geração de tecnologia. A rede suportaria o mesmo modelo de escala idealizado que permite para servidores e armazenamento, permitindo a adição incremental da capacidade da rede-mesmo que de uma tecnologia diferente da que foi implantada anteriormente-para fornecer um aumento proporcional da capacidade e interoperabilidade nativa para toda a construção de dispositivos.

Segundo, embora a largura de banda em escala de construção uniforme seja uma força, torna-se limitador quando você considera que as redes de data center são inerentemente multi-inquilinos e continuamente sujeitas a manutenção e falhas localizadas. Uma rede de data center única hospeda centenas de serviços individuais com níveis variados de prioridade e sensibilidade à largura de banda e variação de latência. Por exemplo, servir os resultados da pesquisa na web em tempo real pode exigir garantias de latência em tempo real e alocação de largura de banda, enquanto um trabalho de análise de lote multi-hora pode ter requisitos de largura de banda mais flexíveis para curtos períodos de tempo. Diante disso, a rede de data center deve alocar largura de banda e caminho para serviços com base em padrões de comunicação em tempo real e otimização com reconhecimento de aplicativos da rede. Idealmente, se 10% da capacidade da rede precisar ser retirada temporariamente para uma atualização, então 10% não devem ser distribuídos uniformemente em todos os inquilinos, mas repartida com base nos requisitos de aplicativos individuais e prioridade.

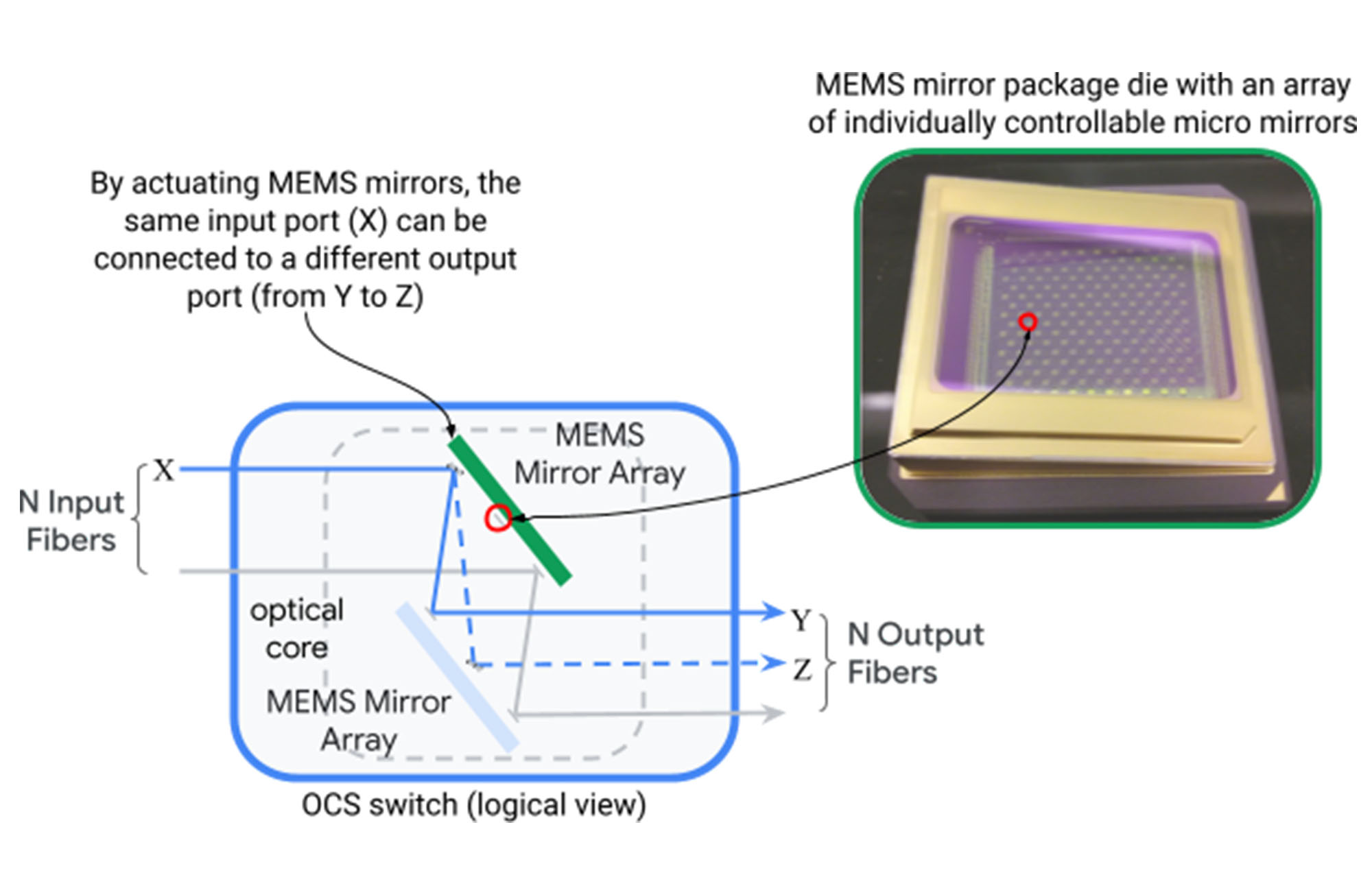

Abordar esses desafios restantes parecia impossível no início. As redes de data center foram construídas em torno de topologias hierárquicas em escala física maciça, de modo que o suporte à heterogeneidade incremental e a adaptação dinâmica de aplicativos não pudesse ser incorporada ao design. Nós quebramos esse impasse desenvolvendo e introduzindo Comutação de circuito óptico (OCS) na arquitetura Júpiter. Um interruptor de circuito óptico (representado abaixo) mapeia uma porta de entrada de fibra óptica para uma porta de saída dinamicamente através de dois conjuntos de espelhos de sistemas microeletromecânicos (MEMS) que podem ser girados em duas dimensões para criar mapeamentos arbitrários de porta-porta.

Figo. A operação de um único dispositivo OCS mapeando a entrada de fibras de saída N Via MEMS espelhos.

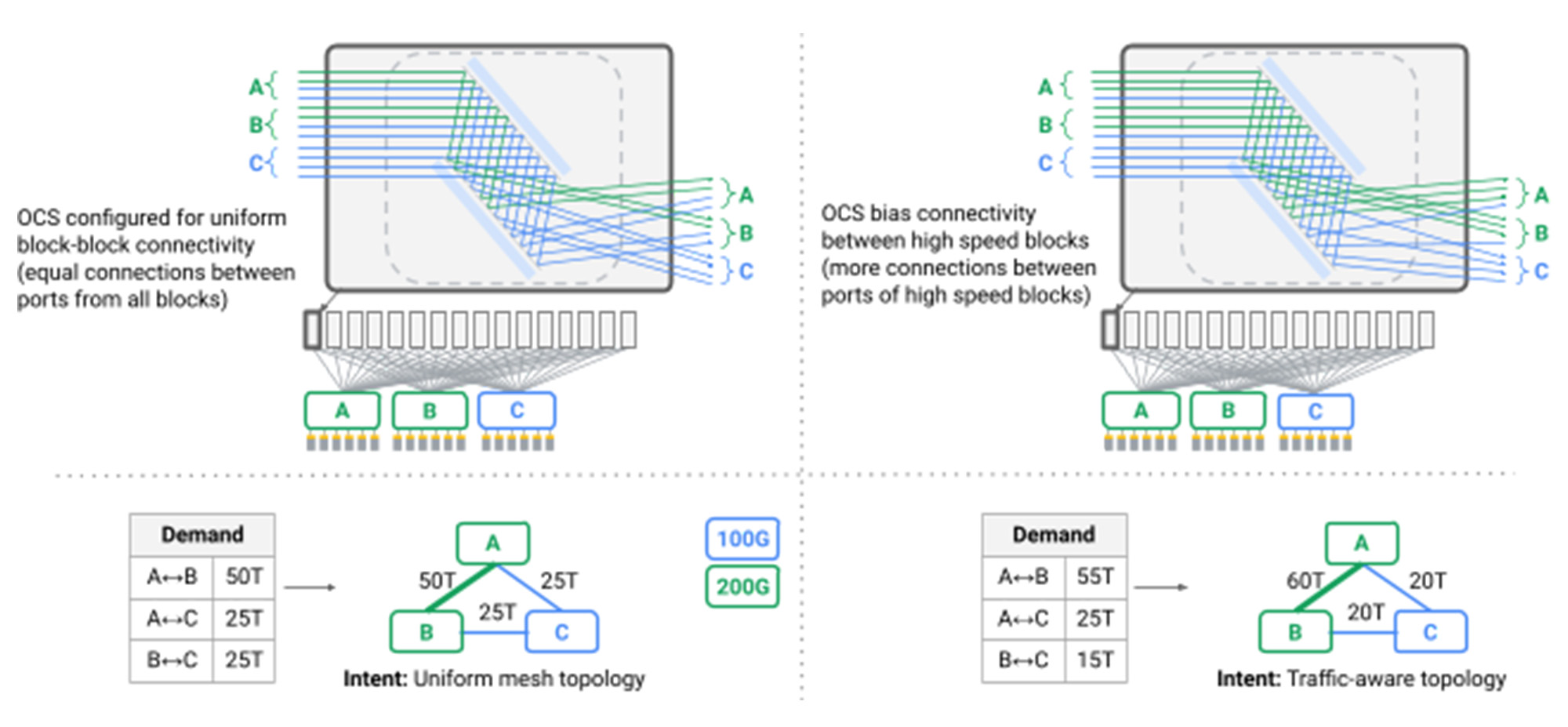

Tivemos o insight de que poderíamos criar topologias lógicas arbitrárias para redes de data center, introduzindo uma camada de intermediação de OCS entre interruptores de pacotes de data center, como mostrado abaixo.

Figo. Blocos de agregação fisicamente conectados via fibras aos interruptores OCS. Uma topologia lógica pode ser realizada configurando cada comutador OCS para conectar uma permutação de entrada para fibras de saída.

Fazer isso exigia que construíssemos OCs e transceptores nativos de WDM com níveis de escala, fabricação, programação e confiabilidade nunca alcançados antes. Enquanto a pesquisa acadêmica investigou os benefícios dos interruptores ópticos, a sabedoria convencional sugeriu que a tecnologia OCS não era comercialmente viável. Em vários anos, projetamos e construímos Apollo OCS Isso agora forma a base para a grande maioria de nossas redes de data center.

Um benefício saliente do OCS é que nenhum roteamento de pacotes ou análise de cabeçalho está envolvida em sua operação. OCS simplesmente reflete a luz de uma porta de entrada para uma porta de saída com precisão incrível e pouca perda. A luz é gerada através da conversão eletro-óptica em transceptores WDM já necessários para transmitir dados de maneira confiável e eficiente nos edifícios de data centers. Portanto, OCS se torna parte do infraestrutura de construção, é a taxa de dados e o comprimento de onda agnóstico e não requer atualizações, mesmo quando a infraestrutura elétrica passa das taxas de transmissão e codificação de 40 GB/s a 100 GB/s a 200 GB/s – e além.

Com uma camada de OCS, eliminamos a camada da coluna de nossas redes de data center, em vez de conectar blocos de agregação heterogênea em uma malha direta, pela primeira vez vai além das topologias Clos no data center. Criamos topologias lógicas dinâmicas que refletiam a capacidade física e os padrões de comunicação de aplicativos. Reconfigurar a conectividade lógica vista pelos interruptores em nossa rede agora é um procedimento operacional padrão, evoluindo dinamicamente a topologia de um padrão para outro, sem impacto visível de aplicação. Fizemos isso coordenando drenos de link com software de roteamento e reconfiguração do OCS, confiando em nosso Software Orion Software definido pelo plano de controle de rede para orquestrar perfeitamente milhares de operações dependentes e independentes.

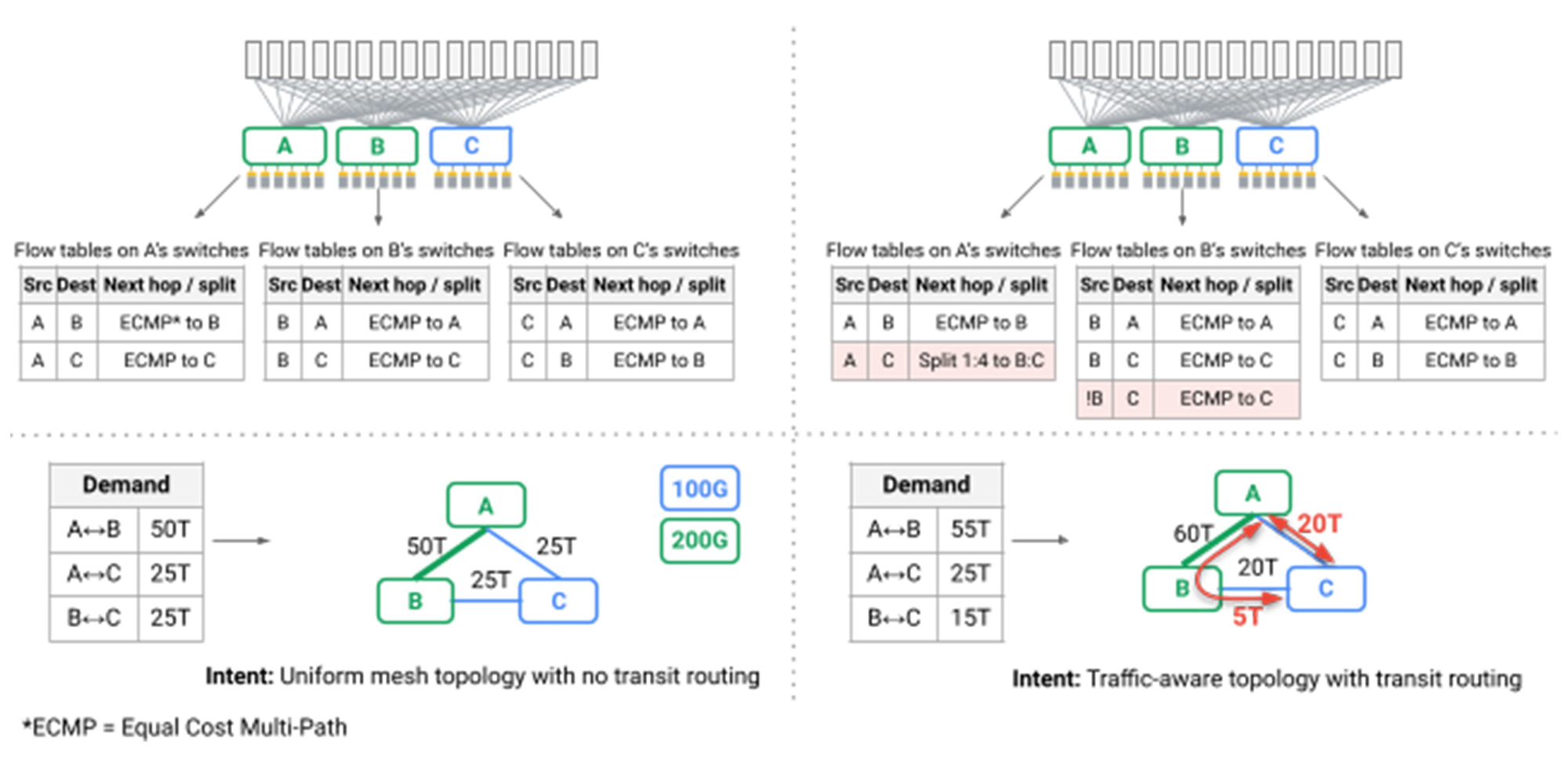

Figo. Múltiplos OCs alcançando engenharia de topologia

Um desafio particularmente interessante foi que, pela primeira vez, o roteamento mais curto do caminho sobre as topologias de malha não poderia mais fornecer o desempenho e a robustez exigidos por nosso data center. Um efeito colateral das topologias Clos tipicamente implantadas é que, embora muitos caminhos estejam disponíveis através da rede, todos eles têm o mesmo comprimento e capacidade de link, de modo que essa distribuição de pacotes alheia, ou Balanceamento de carga valente, fornece desempenho suficiente. Em Júpiter, alavancamos nosso plano de controle SDN para introduzir dinâmico Engenharia de Tráfego, Adotando técnicas pioneiras para o Google’S B4 WAN: Dividimos o tráfego entre vários caminhos mais curtos e não mais curtos enquanto observamos a capacidade do link, os padrões de comunicação em tempo real e a prioridade do aplicativo individual (setas vermelhas na figura abaixo).

Figo. Tabelas de fluxo nos interruptores executam engenharia de tráfego

Tomados em conjunto, temos iterativamente re-arquitetado completamente as redes de data center de Júpiter que Power Google’S computadores em escala de armazém, introduzindo vários primeiros do setor ao longo do caminho:

- Circuito óptico muda como ponto de interoperabilidade para redes em escala de construção, suportando perfeitamente tecnologias heterogêneas, atualizações e requisitos de serviço.

- Topologias de rede baseadas em malha direta para maior desempenho, menor latência, menor custo e menor consumo de energia.

- Topologia em tempo real e engenharia de tráfego para adaptar simultaneamente a conectividade e o caminho da rede para corresponder aos padrões de prioridade e comunicação do aplicativo, enquanto observa a manutenção e as falhas em tempo real.

- Atualizações de rede sem acerto com adição/remoção de capacidade localizada, eliminando a necessidade de caro e trabalhoso “todos os serviços fora” Atualizações de estilo que anteriormente exigiam centenas de clientes e serviços individuais para mover seus serviços para o tempo de inatividade prolongado de construção.

Embora a tecnologia subjacente seja impressionante, o objetivo final do nosso trabalho é continuar a oferecer desempenho, eficiência e confiabilidade que juntos fornecem recursos transformadores para os serviços distribuídos mais exigentes que alimentam o Google e o Google Cloud. Como mencionado acima, nossa rede Júpiter consome 40% menos energia, incorre 30% menos custo e oferece 50x menos tempo de inatividade que as melhores alternativas que conhecemos, enquanto reduz a conclusão do fluxo em 10% e melhorando a taxa de transferência em 30%. Temos orgulho de compartilhar detalhes desse feito tecnológico no SigComm hoje e esperamos discutir nossas descobertas com a comunidade.

Congratulations and thank you to the countless Googlers that work on Jupiter everyday and to the authors of this latest research: Leon Poutievski, Omid Mashayekhi, Joon Ong, Arjun Singh, Mukarram Tariq, Rui Wang, Jianan Zhang, Virginia Beauregard, Patrick Conner, Steve Gribble, Rishi Kapoor, Stephen Kratzer, Nanfang Li, Hong Liu, Karthik Nagaraj, Jason Ornstein, Samir Sawhney, Ryohei Urata, Lorenzo Vicisano, Kevin Yasumura, Shidong Zhang, Junlan Zhou, Amin Vahdat.

1. Um bloco de agregação compreende um conjunto de racks de máquina (computação/armazenamento/acelerador), incluindo interruptores de primeira linha (TOR) conectados por uma camada de interruptores normalmente co-localizados.